Plusieurs agents. Une seule vérité. Nous ne faisons confiance à aucun modèle d'IA individuel. Nous les forçons à vérifier mutuellement leur travail — et nous révélons chaque divergence à vos superviseurs.

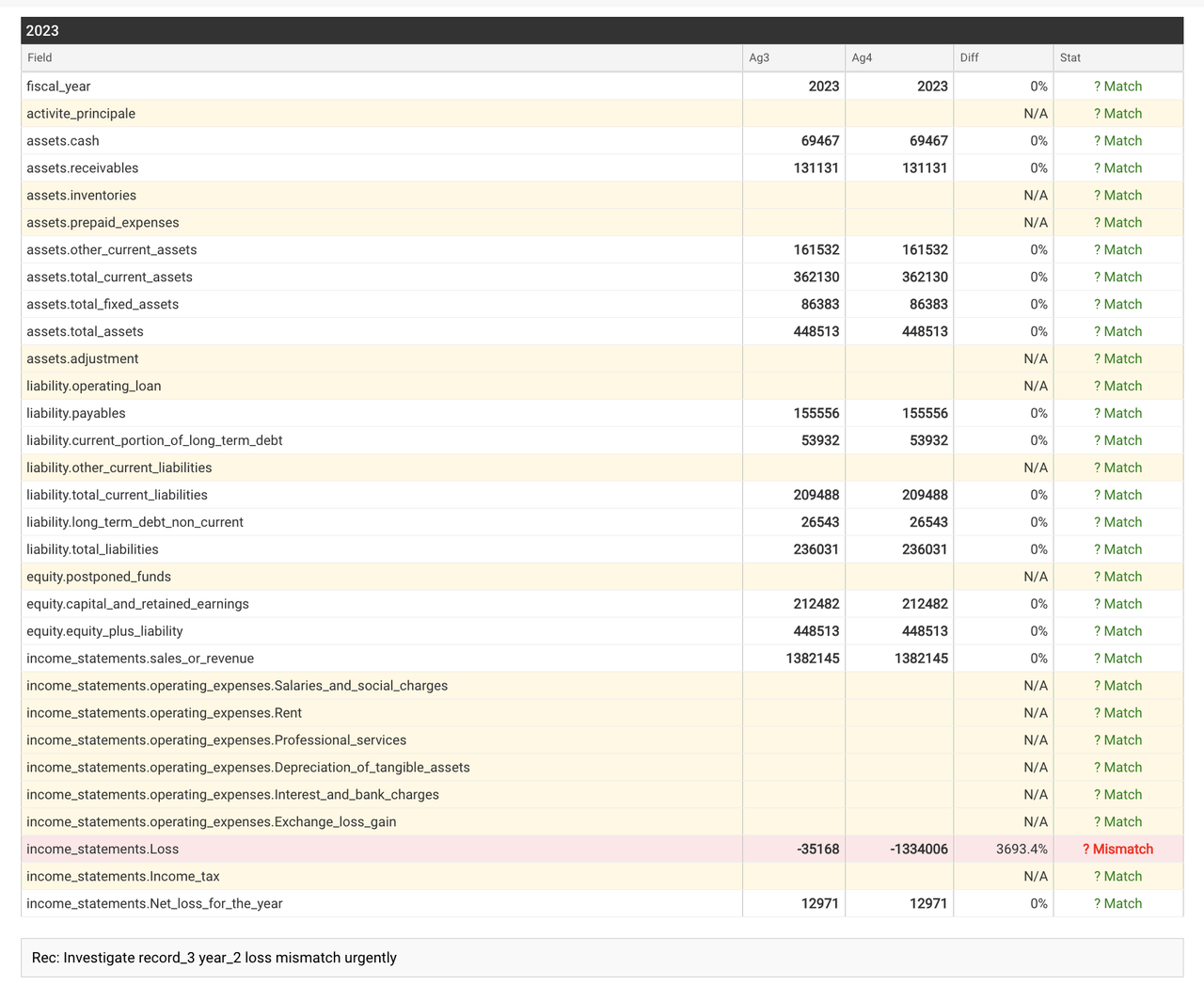

Chaque point de donnée est analysé par des agents d'IA indépendants. Lorsqu'ils sont d'accord, vous obtenez une extraction validée. Lorsqu'ils divergent — même sur un seul champ — le système s'arrête et escalade.

Les autres fournisseurs cachent l'incertitude derrière des scores de confiance.

Nous la révélons — pour que vos superviseurs puissent agir.

La responsabilité juridique réside dans les cas marginaux. Nous ne les cachons pas ; nous les mettons en lumière.

Lorsque notre moteur de consensus multi-agent détecte une ambiguïté, il ne devine pas. Il verrouille le flux et dirige le point de donnée spécifique vers la file d'exception de votre analyste.